【环球时报军事7月31日报道,环球时报特约记者石流峰】人工智能(AI)技术是否应该用于战争?机器人可以被授权杀人吗?这是国外科技学术界反复争论的热点话题。美国《华尔街日报》29日的一篇报道提出了与科学家完全相反的观点,再次引起人们对军事人工智能技术乃至智能战争的关注和关注。

杀戮还是怜悯?

将人工智能用于军事目的甚至部署在战场上,一直是许多外国科技专家强烈反对的决定。科学家警告说,智能机器人容易受到黑客攻击,并可能被劫持以攻击无辜的人。

去年,116 位全球人工智能和机器人专家联合发表公开信,呼吁联合国采取行动取缔“自动杀人机器”,称其为“恐怖武器”。 4 月,超过 3000 名谷歌员工联名致函谷歌首席执行官桑达尔·皮查伊,反对该公司参与五角大楼的军事人工智能项目 Maven。该项目使用机器人深度学习和人工智能分析,并应用计算机视觉技术帮助美国国防部从图像和视频中提取和识别关键物体目标。谷歌高管被迫做出决定,Maven 项目合同将于 2019 年到期,此后不再与五角大楼续签。

包括 SpaceX 首席执行官埃隆·马斯克在内的 2,400 名机器人研究人员和工程师最近在斯德哥尔摩承诺“绝不参与致命自主武器系统的开发和开发”。

但与这些反对智能武器的观点不同,美国《华尔街日报》29日提出了完全相反的观点。报告认为,从地毯式轰炸、大威力核弹到精确制导武器,人类离精确杀伤越来越近。 “智能武器只会减少战争中的意外伤害和附带伤害,不会带来更大的伤亡。”

报告特别强调,虽然近年来美国无人机多次意外伤害平民,但这并不是智能武器的错,而是情报识别的问题。五角大楼组建了算法作战跨职能团队,并开发了Project Maven项目,以更准确地识别和杀死恐怖分子和其他敌人坦克大作战官方版,防止无辜平民受到意外伤害。因此,谷歌“如果真的是为了和平,就应该多为战争做好准备。”

军用 AI 能做什么?

用于军事乃至战争的人工智能技术远不止杀戮机器人。最先进的人工智能技术已经应用于许多防空和反导预警系统。许多防空导弹防御系统的操作人员与系统配合,识别并确认敌方目标后,发射拦截导弹,然后由系统自动探测和探测。拦截目标。

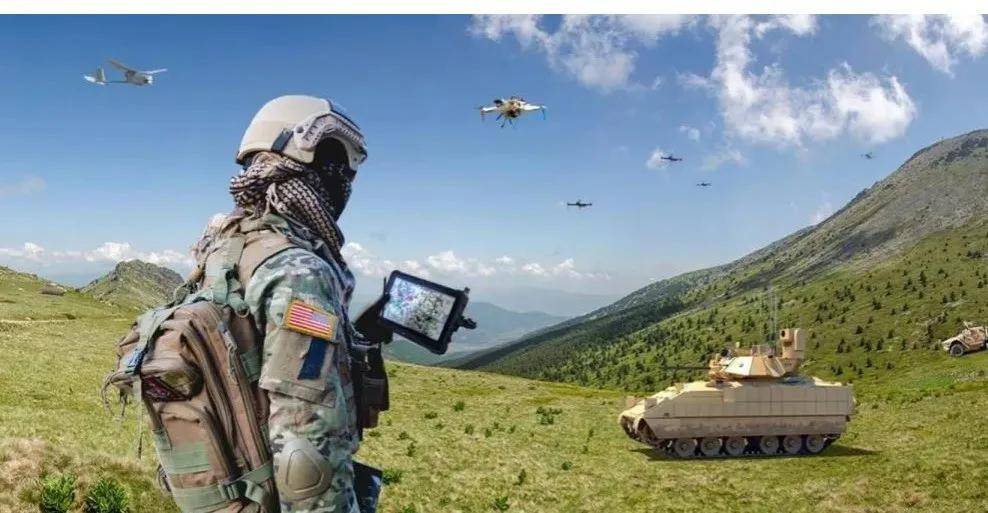

近年来,依托大数据发展起来的人工智能技术,各种武装机器人、无人机成为智能武器的雏形。这也是科学家们最反感的目标。美国陆军、海军、空军和海军陆战队都开发了多种智能武器平台。美国X-47B无人机已在多艘航母上成功起降。美国陆军和海军陆战队还为M1A2主战坦克和“阿帕奇”武装直升机研制了翼车和翼兵,试图发展“有人与无人”的新型作战模式。

在更高级别的战争指挥和作战规划方面,人工智能也在取得突破。例如坦克大作战官方版,一场 20 分钟的大型空战,需要 40 到 50 人 12 小时策划,但在 AI 的协助下,预计将在 1 小时内完成策划。据报道,俄罗斯军方正在应用人工智能和大数据技术,模拟使用软件代替士兵做出作战决策,以应对闪电般的军事打击。

智能军备竞赛已经开始

2008 年,美国海军研究办公室发布了一份报告,承认用于战争的自主机器人不能承担法律责任。 “目前机器人无法区分平民和士兵,不能对其行为负责。未来的无人战争,战斗的主体将远离战场,无人武器会在一瞬间杀死人。” “非人性化”的方式。在没有战争苦难的情感体验的情况下承担战争风险的道德规范。类似于电影《终结者》的末日场景,是很多科学家担心的终极噩梦。然而,截至目前,世界上还没有关于军事智能技术的具体规定,国际社会也没有明确支持限制或禁止此类武器系统。条约。

值得注意的是,美军发起的“第三次抵消战略”认为,以智能部队、自主装备、无人作战为标志的军事变革风暴即将来临。美军计划初步打造智能化 到2050年,美军作战平台、信息系统、指挥控制等将全面智能化甚至无人化,实现真正的“机器人战争”。美国国防部去年 8 月表示,未来的人工智能战争不可避免,美国需要“立即采取行动”,加速人工智能战争技术的发展。俄罗斯也在开发多个智能无人作战平台项目。俄军“天王星6”无人扫雷艇已在叙利亚战争中投入使用。苏霍伊的“猎人”远程重型无人机也将于今年年底首飞。根据历史经验,人类理性可能难以阻止新技术军事化的步伐。军事情报时代的到来或许只是时间问题。

看完这条新闻后你的表情是什么?